telegeram中文版安卓版下载

关于tokenizerpython的信息

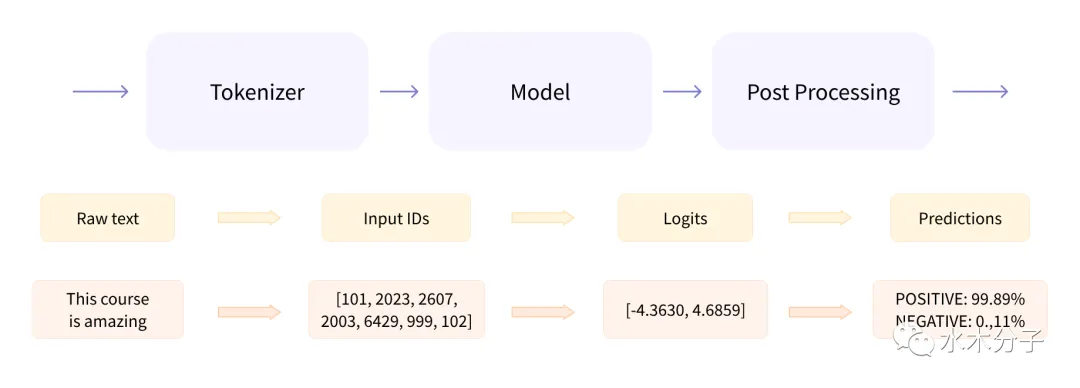

generated_text=tokenizerdecodeoutput0,skip_special_tokens=Trueprintgenerated_text```机器翻译 格拉菲特模型可以用于机器翻译,将一种语言的文本翻译成另一种语言的文本以下是一个使用格拉菲特模型进行中英文翻译的例子```python prompt=quot我爱你quotinput_ids=tokenizerencodeprompt,return_。

jieba库是一款优秀的 Python 第三方中文分词库,jieba 支持三种分词模式精确模式全模式和搜索引擎模式1精确模式 试图将语句最精确的切分,不存在冗余数据,适合做文本分析2全模式 将语句中所有可能是词的词语都切分出来,速度很快,但是存在冗余数据3搜索引擎模式 在精确模式的基础上。

精准中文分词采用bigram隐马模型,实体名词识别采用条件随机场可定制支持用户自定义词典和命名实体识别规则易用提供简洁易用的API,方便二次封装HCT提供了JavaPython等多种版本以Java版本为例,首先需要在maven中引入相应的依赖,然后创建一个Tokenizer对象,即可使用分词功能搜索引擎中文。

按照功能分类的Boost库列表按照实现的功能,Boost可为大致归入以下20个分类,在下面的分类中,有些库同时归入几种类别1 字符串和文本处理a Conversionb Formatc IOStreamd Lexical Caste Regexf Spiritg String Algoh Tokenizeri Wavej Xpressive2 容器a Arrayb Bimapc Circular。

在Pythonpythonrunc中,我们会在243行设置断点,跟踪CPython调用_PyParser_ASTFromFile将字符串转换为抽象语法树的过程接着,程序会进入_PyPegen_run_parser_from_file_pointer,进行词法和语法分析这个阶段从_PyTokenizer_FromFile开始,创建tok_state,初始化语法分析器,然后调用_PyPegen_run_pars。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~