telegeram安卓下载官网最新版本

tokenization中文的简单介绍

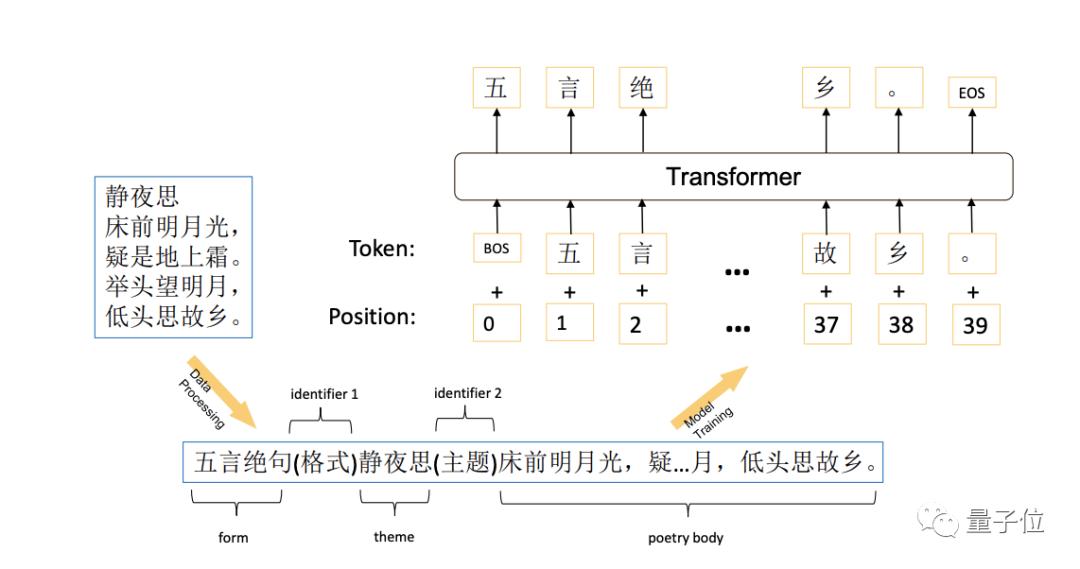

上面的三种tokenization模型都假设文本中使用空白符来分割单词,但并非所有语言都这样做,如中文解决方式之一是使用与语言相关的预分词器,如XLM,来处理SentencePiece在SentencePiece A simple and language independent subword tokenizer and detokenizer for Neural Text Processing Kudo et al, 2018中引入,提。

Characterbased 分词粒度更细,字符级无意义,输入长度增加,适用于中文,但初始字符嵌入无明确含义Subword tokenization,如BPEByte Pair EncodingWordPieceUnigram LM,它们在多语言模型中广泛应用,旨在平衡上述两种方法BPE,由OpenAI在GPT2中采用,通过迭代合并最常出现的字符对,直至满足停止。

此外另一种词典是characterlever,即以单个字母或汉字中文为基本单词设计词典,这种方法理论上可以解决未登录词的问题,因为所有的词都是由字母组成的,但是这样做的缺点是模型粒度太细,缺少语义信息,实际也有人做过实验证明这种方法不好后来2016年rich等人提出了基于subword来生成词典的方法,这种方法。

5 BPE的优点与适用范围BPE在大语料库中表现出色,能平衡词典大小和编码步骤中文通常使用分词而非BPE,因为汉字无法拆分6 实现与应用使用BPE可以借助subwordnmt包,无需从零开始其他Subword方法如Unigram Based Tokenization和WordPiece也有其价值参考文献WordPieceBPE详解及代码Bert系列相关分词器。

中文翻译Visa 提供各种奖励和优惠,具体取决于地区和发卡银行5 安全性Mastercard 和 Visa 都提供各种安全措施来保护持卡人的信息和交易安全例句Mastercard uses advanced security features like EMV chips and tokenization to protect cardholders#x27 information中文翻译Mastercard 使用高级。

tokenization errors的负面影响,而且更具有表达性和嵌入输入句子的灵活性 NMT特点 传统的统计机器翻译模拟管道pipeline中源语言和目标语言之间的潜在结构和对应关系, NMT则是训练了一个统一的编码解码神经网络,其中编码器将输入的句子映射成固定长度的向量,解码器从编码的向量生成翻译基于词格的递归神经网络 NMT。

ublic class StringTokenizerextends Objectimplements EnumerationltObjectstring tokenizer 类允许应用程序将字符串分解为标记tokenization 方法比 StreamTokenizer 类所使用的方法更简单StringTokenizer 方法不区分标识符数和带引号的字符串,它们也不识别并跳过注释可以在创建时指定,也可以根据每个标记来。

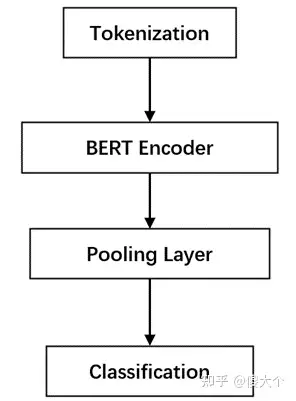

在使用BERT时,首先要下载相关的代码和预训练模型这些代码通常包括modelingpy, optimizationpy, tokenizationpy, 和run_classifierpy对于文本相似度任务,重点在于修改run_classifierpy部分中文预训练模型如chinese_L12_H768_A12zip中,包含了bert_configjson模型参数,bert_model。

tokenizer callable or None default复写the string tokenization step,但保留preprocessing and ngrams generation steps这个参数可以自己写stop_words string ‘english’, list, or None default如果是‘english’, a builtin stop word list for English is used如果是a。

MBSP与Pattern同源,同出自比利时安特卫普大学CLiPS实验室,供给了Word Tokenization, 语句切分,词性标示,Chunking, Lemmatization,句法剖析等根本的文本处理功用,感兴趣的同学可以重视关于 Python文本处理工具都有哪些,环球青藤小编就和大家分享到这里了,学习是永无止境的,学习一项技能更是受益终身,所以。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~