telegeram中文版安卓版下载

tokenizer函数结果保存、tokenize函数python用法

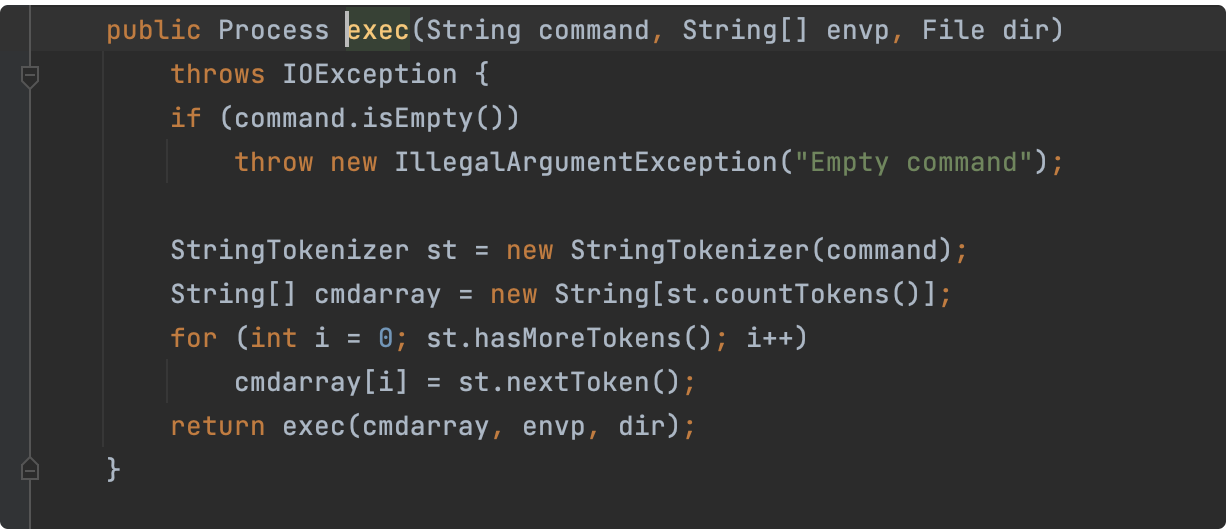

1、tokenizer 用于数据预处理,自动填充输入至最大长度,便于训练过程,并在训练中断或重用模型时保存分词器计算指标 compute_metrics函数用于评估时计算指标,接收EvalPrediction对象并返回指标字典回调函数 允许自定义训练循环,可添加到默认回调函数列表中,使用Trainerremove_callback移除优化器 包含优化器;另外,还可以通过jiebaTokenizer创建自定义分词器,并且支持词典自定义和动态调整词频例如,通过`jiebacut#39如果放到post中将出错#39, HMM=False`,你可以看到分词结果为了提高精度,可以使用`suggest_freq`函数调整词频实战中,一个实例是分析小说判官txt中的人物名词和地名的词频,通过词;那就意味着每次onClick的函数都是一个全新的函数,那就会造成这个回调函数明明没有变,都会被认为变了,那就必须进行一系列的更新,那么如果能把这个回调函数缓存起来,更新的时候,就不要再创建了 未进行缓存事件处理程序之前的编译functiontokenizerinputfunctionparsetemplateconsttokens=tokenizertemplate;#8195#8195 它是一个很方便的字符串分解器,主要用来根据分隔符把字符串分割成标记Token,然后按照请求返回各个标记这个过程称为Tokenization,实际上就是把字符序列转换成应用程序能够理解的多个标记你可以用以下三种构造函数中的任意一种创建StringTokenizer分解器StringTokenizerString sInput;```python importtorch fromtransformersimportGPT2Tokenizer,GPT2LMHeadModel tokenizer=GPT2Tokenizerfrom_pretrained#39gpt2#39model=GPT2LMHeadModelfrom_pretrained#39gpt2#39,return_dict=True```这里,我们使用了PyTorch库和transformers库中的GPT2Tokenizer和GPT2LMHeadModel函数GPT2Tokenizer函数用于将。

2、StringTokenizer的实例创建方式取决于returnDelims 标记位的设置如果returnDelims标记为true,那么分隔符字符本身也被视为标记这意味着标记可以是一个分隔符字符,或者是一串连续的非分隔符字符相反,如果returnDelims标记为false,那么分隔符字符用于分隔标记在这种情况下,标记由一系列连续的非分隔。

3、空格“”系统默认的构造函数只有一个实参,默认空格作为分隔符public StringTokenizerString theString你要定义自己的分隔符集合时,得加个参数public StringTokenizerString theString,String delimiters因为delimiters是复数,所以可以有多个分隔符,比如String delimiters=“\n,”这三种分隔符不用;2 同一个数组可以保存不同的对象比如一个数组NSArray,这种数组里面可以保存各种不同的对象,比如这个数组里myArray lt 0 float 23433f 1 @”我是个好人” 2 NSImage * 俺的美图 3 @”我真的是好人”这是一个由4个东西组成的数组,这个数组包括一个浮点数,两个字符串和一个图片;基于单词的tokenization方法通过空白符和标点符号并使用特定规则将文本拆分成tokens,可以使用正则表达式或Python的split函数实现例如,文本“Hello world!”可以被拆分成tokens“Hello”和“world!”Spacy和Moses是基于规则的tokenizer的两种流行选项基于单词的tokenization方法可能会生成非常大的词汇表Transformer XL的;根据StringTokenizer的文档,其构造函数的第二个参数,是一个String,表示所有起分割作用的character也就是说,StringTokenizer只能用单个character做分隔符,一旦遇到w或者c就会分割一下如果题主想用“wc”整体作为分隔符,可以直接用String类的split方法;在语言处理的上下文中,比如词法分析器Lexer和语法分析器Parser的构建过程中,tokenizer是不可或缺的Lexer通过tokenizer函数将输入文本划分为一个个token,这些token被用于后续的语法分析和处理例如,在Java的StreamTokenizer类中,用户可以通过定义规则来识别并提取输入流中的各种标记符号,从而实现对文;使用 Keras 的 Tokenizer 函数将每个语句转化为一个单词 id 的序列使用该函数来标记化英文语句和法文语句函数 tokenize 返回标记化后的输入和类Padding 通过使用 Keras 的 pad_sequences 函数在每个序列最后添加零以使得所有英文序列具有相同长度,所有法文序列具有相同长度预处理流程 实现预处理函数;在使用NLTK的过程中,需要注意词形还原接口的lemmatize函数需要传入相应的词性参数才能得到最佳结果NLTK的这些功能已经集成到AINLP公众号的NLP测试模块中,读者可以直接关注公众号进行测试NLTK是一个功能丰富广泛使用的自然语言处理工具,对于初学者和研究者来说都是一个很好的资源除了上述功能,NLTK还。

4、Tokenizer是执行Tokenize操作的工具或函数不同的编程语言和库可能提供不同的Tokenizer实现例如,在Python中,NLTK库和Spacy库都提供了Tokenizer功能这些Tokenizer能够处理多种语言,并提供了丰富的选项和功能,如分词词性标注命名实体识别等总的来说,TokenTokenize和Tokenizer是自然语言处理和文本分;继承自fastllm,包含纯虚函数如加载权重模型推理保存低比特模型热身等chatglmmoss和vicuna继承自basellm,实现具体模型,函数与basellm类似fastllm结构体与属性解析FileBuffer 文件读写操作,包括读取各种类型数据和文件写操作Data操作 包括数据拷贝统计扩容转置计算权重和等Tokenizer;数据集的处理包括查看划分选取与过滤,以及数据映射例如,使用map函数为每个title添加前缀数据处理完成后,map函数支持批量处理,显著提高效率例如,批量处理与单条处理的对比最后,处理完的数据可以保存到本地磁盘,以便下次快速加载加载本地数据集时,无论是格式化数据还是使用加载脚本,都有;这样应该就放心CountVectorizer处理结果是不是自己想要的了哇哈哈最后看下两个函数fitraw_documents, y Learn a vocabulary dictionary of all tokens in the raw documentsfit_transformraw_documents, y Learn the vocabulary dictionary and return termdocument matrixfit;2 批次大小每次迭代处理的数据量,影响训练速度与模型性能3 迭代次数训练循环的次数,决定模型学习的深度4 优化器选择优化算法,影响训练过程的稳定性和效率5 损失函数定义目标函数,指导模型优化过程以英语影评数据集为例,加载预训练模型bertbasecased的tokenizer,进行文本。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~